イントロブログ

**

イントロブログ

アフリカのAIデータセンター・ブーム:ナイジェリア、ケニア、南アフリカのビジネスチャンス

アフリカは、ナイジェリア、ケニア、南アフリカの急成長市場に牽引され、世界の次の主要AIインフラフロンティアとして浮上している。クラウド地域、海底ケーブル、再生可能エネルギー、超大規模データセンターに何十億ドルもの資金が流れ込み、アフリカ大陸はデジタル拡張の新時代へと加速している。モバイルファーストの若い人口とフィンテックの急速な普及がこの変革に拍車をかけ、コンピュート、コネクティビティ、クラウドサービスに対する強い需要を生み出している。投資家にとって、アフリカは2027年までに50億ドルに達する見込みの市場において、初期段階の貴重な成長をもたらしてくれる。

ラテンアメリカのAIインフラ:ブラジルとメキシコのデータセンター

サンパウロは100メガワットの容量を持つラテンアメリカのデータセンターの首都として浮上している。メキシコのニアショアリング・ブームは、500億ドルの外国投資を引き寄せている。メキシコのクラウドインフラに対するAWSの100億ドルのコミットメントも、ラテンアメリカのAI市場における前例のない機会を示唆している。ブラジルは2億1,500万人の市民を擁し、2,000億ドル規模の地域最大のデジタル経済を生み出している。

AIインフラチームの構築2025年に向けたNVIDIA認定ロードマップ

85,000人のGPUエンジニア不足で給与は35万ドルを超える。NVIDIAは97,000人の需要に対し、年間12,000人しか認定していない。この2025年のロードマップを参考に、チームを作りましょう。

中東のAI革命:UAEとサウジアラビアの1000億ドル超のインフラ計画

サウジアラビアの5,000億ドル規模のNEOM、UAEのAI大臣、カタールの100億ドル規模のデジタル・ファンドは、AI主導の成長に対する地域別のアプローチを示している。湾岸諸国の3兆ドルの富に支えられ、AIのインフラ投資は2030年までに1000億ドルを超えるだろう。マイクロソフト、オラクル、AWSのような世界的なハイテク大手は多額の資本を投じている。この分析では、各国の戦略を比較し、中東の新興AI市場がいかに独自の国家モデルと国境を越えた機会を提供しているかを示している。

Google TPU v6e vs GPU:ドルあたり4倍優れたAI性能ガイド

Google TPU v6e、AIトレーニングでGPUの4倍の性能/ドルを実現。導入戦略、コスト分析、最適なユースケースを学ぶ

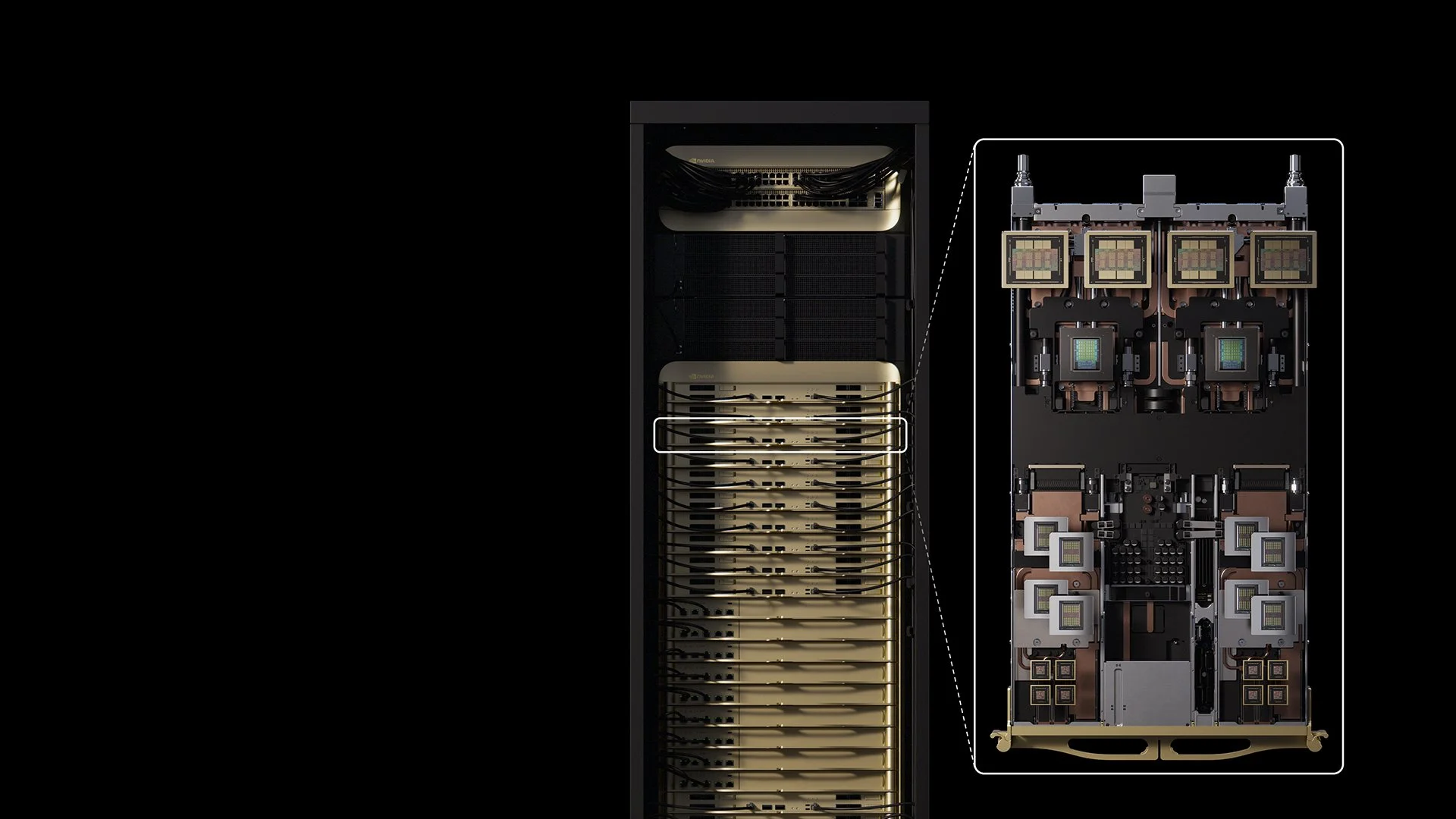

ラックあたり40~250kW:超高密度データセンター・ソリューション

最新のAIは1ラックあたり40~250kWを要求していますが、従来の冷却は15kWで故障します。超高密度インフラ導入のためのエンジニアリング・ソリューションをご覧ください。

VVaterとIntrol、AIデータセンターの未来を再定義するパートナーシップを発表

VVaterとIntrolが提携、持続可能な水技術でAIデータセンターに革命を起こす。4.3億ガロンを処理し、GPUインフラ拡張のためのOpExを80%節約。

NVIDIAベラ・ルービン、600キロワットラックと100万トークンメモリでGPUの常識を覆す

NVIDIAベラ・ルービンは、2027年までにデータセンターを600kWラックに押し上げ、7.5倍の性能向上を実現すると同時に、完全なインフラ変革を要求する。

コアウィーブAIインフラ革命 - 暗号マイニングのスタートアップはいかにして230億ドルの人工知能の基幹企業になったのか?

CoreWeaveは、暗号マイニングからピボットして、23BドルのAIインフラストラクチャー・バックボーンになり、OpenAIの基盤モデルに電力を供給しながら、737%の収益成長を達成した。

LLMハードウェアガイド 2025:価格と仕様

デュアルRTX 5090が70BモデルのH100性能に25%のコストでマッチ。コンシューマ向けGPUからエンタープライズ向けGPUまで、ローカルLLM展開のための完全なハードウェア価格ガイド。

OpenAIのスターゲイト:明日のAIを支える5,000億ドルの合弁事業

OpenAIのStargateは、ソフトバンク、オラクル、MGXとの5億ドルのジョイントベンチャーで、明日の人工知能革命を支える世界最大のAIインフラネットワークを構築している。

イントロール、2025年Inc.5000で14位にランクイン。5000にランクイン

イントロール、Inc.5000」で14位にランクイン、成長率は9594%に達し、AI革命の原動力となるGPUインフラのスペシャリストとして米国で最も急成長しています。

インドのGPUインフラ革命:8万GPUから1000億ドルの投資へ

インドが8万台以上のGPUを導入、2027年までに1,000億ドルの投資パイプライン、アジアで最も急成長するAIインフラ市場として年平均成長率34.4%を達成。

エヌビディア・オムニバース50TドルのフィジカルAIオペレーティングシステム

NVIDIA Omniverseが252社以上の企業を30~70%の効率向上で支援。50兆ドルの物理的AI OSは、製造、ロボット工学、自律走行車を変革します。

NVIDIAのFP4推論が50倍の効率を実現

FP4推論は3.5倍のメモリ削減で25~50倍のエネルギー効率を実現。DeepSeek-R1が250トークン/秒以上を達成。0.02ドル/トークンの時代が到来。

マレーシアの150億ドルのAI革命が東南アジアのデジタル未来を動かす

マレーシア、AI投資で150億ドル超を確保、地域初のH100 GPUプラットフォームを導入。ジョホール州が東南アジアのAI大国へと変貌を遂げ、テック大手がしのぎを削る。

AIに電力を供給する小型モジュール型原子炉(SMR):100億ドルの原子力革命がデータセンターを変える

テック大手、AIデータセンターに電力を供給する小型モジュール炉に100億ドル以上を投資。原子力発電がAIの945TWhのエネルギー需要を満たすため、2030年までに最初のSMR施設が稼働する。