エヌビディアのComputex 2025革命:データセンターをAI工場に変える

エヌビディアのジェンセン・フアンCEOは、トレードマークの革ジャンを着てComputex 2025のステージに立ち、新しいハードウェアとまったく新しいコンピューティングパラダイムを発表した。半導体大手のエヌビディアは、AIインフラストラクチャー企業へと決定的に変貌を遂げ、フアン氏が「インテリジェンスのインフラストラクチャー」と呼ぶ、電気、インターネットに続く第3の主要インフラ革命の基盤を構築している。

この基調講演は、単なる製品発表ではなく、コンピューティングの展望を再構築するためのNVIDIAの青写真を示すものだった。彼が明らかにした技術的な飛躍、戦略的なピボット、そして市場プレーは、おそらくこのComputexを何年も参照することになるだろう。完全版を見る Computex 2025 Nvidiaキーノート.

NVIDIAの戦略的進化:グラフィックス・カードからインフラ・プロバイダーへ

エヌビディアの変革のストーリーは目を見張るものがある。1993年、ジェンセンは「3億ドルのチップ・チャンス」、つまり相当な市場に目をつけた。今日まで早送りすると、彼は1兆ドル規模のAIインフラストラクチャーのジャガーノートを指揮している。このような爆発的な成長はただ起こるものではない。

基調講演でジェンセンは、今日のNVIDIAを可能にしたターニングポイントを強調しました:

2006:CUDAが登場し、並列コンピューティングの常識を覆した。突然、GPUを一般的なコンピューティングに使うことなど考えたこともなかった開発者たちが、従来のCPUでは不可能だったアプリケーションを構築するようになった。

2016:DGX1は、NVIDIA初の妥協のないAIに特化したシステムとして登場した。今ではほとんど不気味な伏線のように見えるが、ジェンセンは最初のユニットをOpenAIに寄贈し、現在のAI革命につながる計算基盤を効果的に提供した。

2019年:メラノックスの買収により、エヌビディアはデータセンターを統合コンピューティング・ユニットとして再認識できるようになる。

この変革は、エヌビディアの「必要不可欠なインフラストラクチャー企業」としての現在の地位に結実している。この地位は、AI展開のためのグローバルなインフラストラクチャー計画を可能にする、前例のない5年間の公開ロードマップを強調することで黄社長が強調したものである。

パフォーマンス指標の再定義:トークン・エコノミー

エヌビディアは、計算出力の測定方法における根本的なシフトを導入した。FLOPsや1秒あたりの演算といった従来の測定基準ではなく、フアン氏はAIデータセンターを「トークン」(計算知能の単位)を生産する工場と位置づけた:

「企業は、前四半期に何トークンを生産したか、先月は何トークンを生産したかについて話し始めている。もうすぐ、どの工場もそうであるように、私たちも毎時何トークンを生産しているかを議論するようになるでしょう。"

このリフレーミングは、計算機への投資とビジネスの成果を直結させ、AIインフラを従来の産業フレームワークと整合させます。このモデルは、エヌビディアを、計算効率がビジネス能力に直結する新しい経済パラダイムの震源地に位置づけます。

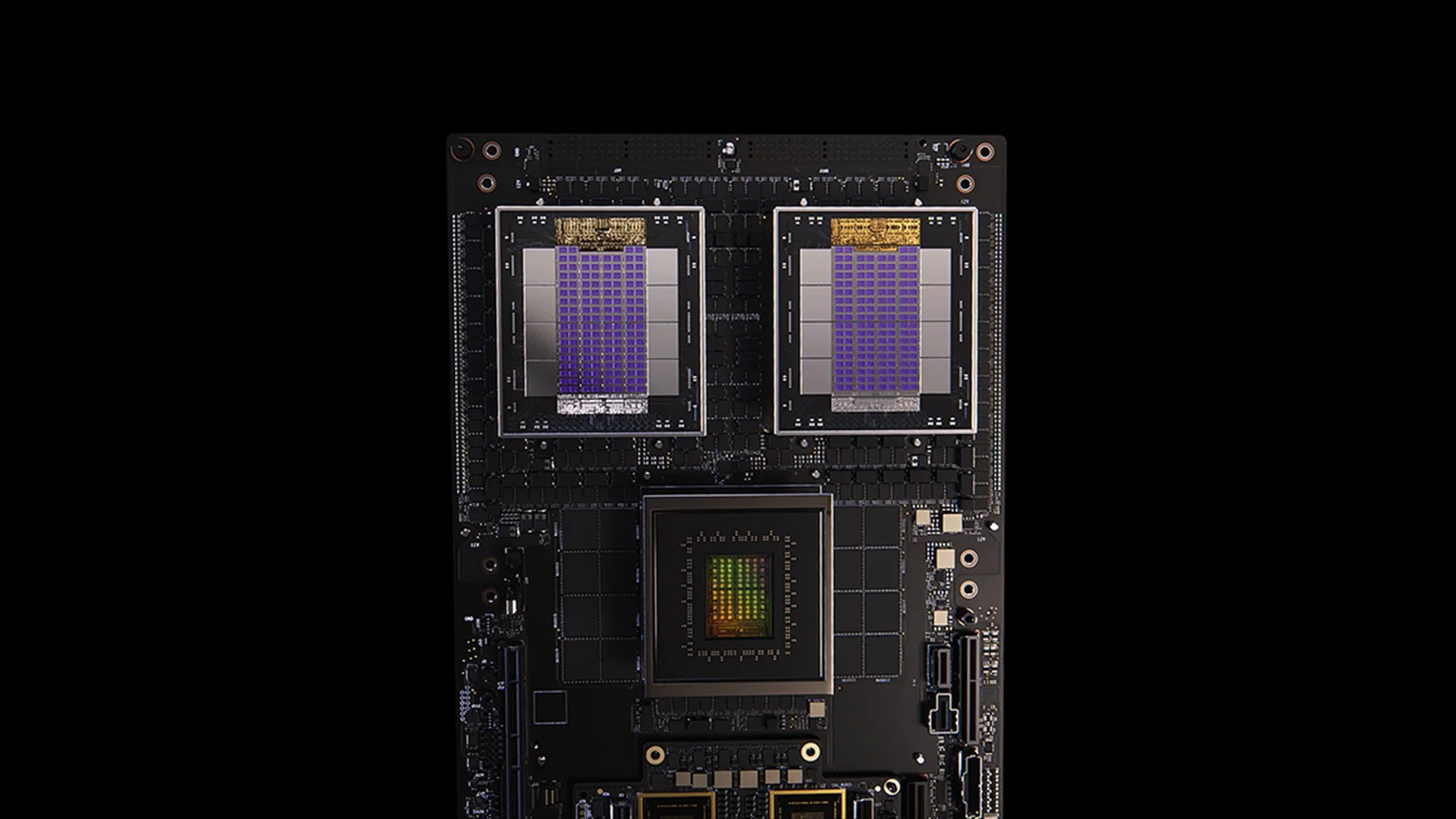

ブラックウェル・アーキテクチャーのアップグレードGB300の仕様と性能指標

GB200システム

BlackwellアーキテクチャのGB300アップデートは、NVIDIAの絶え間ない性能向上サイクルを例証するものです。2025年第3四半期に予定されているGB300は、以下を実現します:

GB200の1.5倍の推論性能向上

1.5倍のHBMメモリ容量

ネットワーク帯域幅が2倍向上

完全液冷設計

既存のシャーシやシステムとの下位互換性

各GB300ノードは、約40ペタフロップスを実現し、18,000個のVolta GPUを必要としたSierraスーパーコンピュータ(2018年頃)全体を実質的に置き換えます。この6年間で4,000倍の性能向上は、従来のムーアの法則を大きく上回るものであり、アーキテクチャ、ソフトウェア、および相互接続の革新を通じて、性能加速に対するNVIDIAの多面的なアプローチを実証しています。

MVLink:相互接続技術の再定義

MVLinkは、NVLinkの登場以来、GPUインターコネクト技術における最も重要な進歩です。このシステムは、ラック全体にわたる計算リソースの完全な分割を可能にし、72個のGPU(144個のGPUダイ)を単一の巨大な計算ユニットに変えます。

技術仕様は驚異的だ:

個別のMVLinkスイッチ7.2TB/秒の帯域幅

MVLinkスパイン:全帯域幅130TB/秒

物理的な実装:正確に長さを合わせた同軸ケーブル5,000本(合計約2マイル)

電力密度:ラックあたり120キロワット(液冷が必要)

その背景として、インターネット全体のピーク時のトラフィックは毎秒約900テラビット(112.5TB/s)であり、MVLinkスパイン1本でピーク時のグローバル・インターネットを上回るトラフィックを処理できることになる。

MVLinkフュージョン:オープンなAIインフラ・エコシステムの構築

MVLink Fusionは、ここ数年でNVIDIAが行った最も革新的なエコシステムかもしれない。NVIDIAは、パートナーにNVIDIAのハードウェアを全面的に押し付けるのではなく、NVIDIAの世界と結びついたセミカスタムAIシステムを構築できるよう、アーキテクチャをオープンにしている。

アプローチは驚くほど柔軟だ:

カスタムASICインテグレーション:特殊なアクセラレーターをお持ちですか?問題ありません。パートナーはMVLinkチップレットをドロップすることで、カスタムシリコンをNVIDIAのエコシステムに接続することができます。これは、NVIDIAが「どんな特殊なハードウェアでも作ってください。

カスタムCPUの統合:CPUベンダーも蚊帳の外ではありません。CPUベンダーはMVLinkのチップ間インターフェイスを直接実装することができ、自社のプロセッサーとBlackwell GPU(または近々発表されるRubenアーキテクチャ)の間に直接ハイウェイを作ることができる。MVLinkは、特定のCPUアーキテクチャに投資している企業にとって非常に重要です。

パートナーの発表は半導体業界にまたがる:

シリコン実装パートナーLCHIP、Astera Labs、Marll、MediaTek

CPUベンダー富士通、クアルコム

EDAプロバイダーケイデンス、シノプシス

このアプローチは、顧客が導入する特定のハードウェアの組み合わせに関係なく、NVIDIAが価値を獲得できるよう戦略的に位置づけており、Huangの率直な発言を反映している:「NVIDIAからすべてを買っていただくことほど嬉しいことはありません。それを皆さんに知ってほしいのです。しかし、あなたがNVIDIAから何かを買ってくれれば、私はとてつもない喜びを感じます。"

エンタープライズAIの導入:RTX Pro EnterpriseとOmniverse Server

RTX Pro EnterpriseとOmniverseサーバーは、従来のIT環境にAI機能を統合するために特別に設計された、エヌビディアの最も重要な企業向けコンピュート製品です:

完全x86互換アーキテクチャ

従来のハイパーバイザーをサポート(VMware、Red Hat、Nanix)

Kubernetesの統合による使い慣れたワークロードのオーケストレーション

Blackwell RTX Pro 6000s GPU(サーバーあたり8個)

800Gb/秒の帯域幅を提供するCX8ネットワーキング・チップ

Hopper H100に対して1.7倍の性能向上

Deepseek R1のような最適化されたモデルで4倍のパフォーマンス

このシステムは、スループット(1秒あたりのトークン数)と応答性(ユーザー1人あたりの1秒あたりのトークン数)の2軸フレームワークで測定される、AI推論の新しいパフォーマンス・エンベロープを確立する。

AIデータプラットフォーム:非構造化データのストレージを再構築する

エヌビディアのAIデータプラットフォームは、エンタープライズ・ストレージに根本的に異なるアプローチを導入する:

「人間はSQLのような構造化されたデータベースを照会する。しかし、AIは非構造化データを照会したがる。彼らはセマンティックを求める。彼らは意味を求める。だから我々は、新しいタイプのストレージ・プラットフォームを作らなければならない"

主なコンポーネントは以下の通り:

NVIDIA AIQ (またはIQ):セマンティッククエリーレイヤー

従来のCPU中心のアーキテクチャに取って代わるGPU加速ストレージノード

学習データの出所を透過的に示す事後学習済みAIモデル

既存のソリューションと比較して、クエリが15倍高速化し、結果が50%向上

このアーキテクチャを導入しているストレージ業界のパートナーには、デル、日立、IBM、ネットアップ、バストが含まれ、包括的なエンタープライズAIデータ管理エコシステムを構築している。

AIオペレーションとロボティクス:インテリジェント・エンタープライズのためのソフトウェア・フレームワーク

基調講演では、2つの重要なソフトウェアフレームワークが紹介された:

AIオペレーション(AIOps):データキュレーション、モデルの微調整、評価、ガードレール、セキュリティなど、企業におけるAIエージェント管理のための包括的なスタック。パートナーは、Crowdstrike、Data IQ、Data Robots、Elastic、Newonix、Red Hat、Trend Microなど。

アイザック・グルート・プラットフォームN1.5:オープンソースのロボット開発エコシステム:

ニュートン物理エンジン(Google DeepMindおよびDisney Researchと共同開発)

Jetson Thor ロボット・プロセッサ

NVIDIA Isaacオペレーティングシステム

グルート・ドリームスが合成軌道データ生成の青写真を描く

ロボット工学の実現にはAIが必要だ。しかし、AIを教えるにはAIが必要なのです」。この再帰的最適化パターンは、生成AIを活用し、限られた人間のデモンストレーションデータを包括的なロボット工学トレーニングセットに拡張する。

AI製造革命における台湾の戦略的ポジション

基調講演の大部分は、AI技術の生産と実装の両方における台湾の極めて重要な役割に焦点を当てたものだった:

台湾の製造企業(TSMC、Foxconn、Wistron、Pegatron、Delta Electronics、Quanta、Wiiwin、Gigabyte)は、デジタルツインの実装にNVIDIA Omniverseを導入している。

TSMCは、CUDA上のAI搭載ツールを使用して、工場レイアウトと配管システムを最適化している。

製造業のパートナーは、バーチャルプランニングや予知保全のために、またロボットシステムをトレーニングするための「ロボットジム」としてデジタルツインを使用している。

フォックスコン、TSMC、台湾政府、エヌビディアは、台湾初の大規模AIスーパーコンピューターを構築している。

ホアン氏は、台北に新しい本社施設である「NVIDIA Constellation」の計画を発表し、NVIDIAの地域に対するコミットメントをさらに強固なものにしました。

テクニカル分析:企業AI戦略の意味するもの

これらの発表は総体的に、いくつかの戦略的意味を持つエンタープライズコンピューティングの包括的な再構築を意味する:

計算規模の要件:推論AI "とエージェント・システムの推論時間性能に対する要求は、初期の大規模言語モデル導入よりも大幅に高い計算要件をもたらすため、大規模なスケールアップとスケールアウトのためのアーキテクチャ計画が必要となる。

エンタープライズAIの分散化:MVLink Fusionエコシステムは、異種AIシステムの構築においてかつてない柔軟性を可能にし、インターコネクト技術を通じてエコシステムにおけるNVIDIAの地位を維持しながら、特殊なAIアクセラレータの採用を加速させる可能性がある。

データセンターからAI工場へのシフト:インフラ投資の価値を測る方法を完全に見直す必要がある。生の計算能力やストレージ容量がすべてを語っていた時代は終わった。今は、システムが1秒あたり、1ワットあたり、1ドルあたり、何単位のAI出力を生成できるかというトークン生産がすべてだ。ジェンセンが、企業は近い将来、製造指標のようにトークン生産を報告するようになるだろうと言ったのは冗談ではなかった。AI工場へのシフトは、私たちがAIインフラ支出を展開し、正当化する方法の経済学を根本的に書き換えるだろう。

デジタル・ツインの統合台湾の主要メーカーがこぞってオムニバースのデジタル・ツインを構築しているという事実が、すべてを物語っている。デジタル・ツインは、最適化に真剣に取り組む企業にとって不可欠なインフラとなっている。企業が物理的プロセスを最適化するためにデジタル・ツインを構築し、同じ環境を使ってAIやロボティクスを訓練し、物理的世界をさらに改善する。これは、加速し続ける継続的な改善サイクルである。

ロボットによる労働力計画エージェント型AIと物理的ロボット工学の融合は、組織が統合されたデジタルと物理的自動化戦略を開発すべきことを示唆しており、労働力計画と施設設計に大きな影響を与える。

ソフトウェア定義インフラ:ハードウェアの発表にもかかわらず、エヌビディアがライブラリとソフトウェアフレームワークに引き続き重点を置いていることは、AIにおける競争上の優位性は、生のハードウェア能力と同様にソフトウェアの最適化によってもたらされることを補強している。

AI工場の変遷をナビゲートする

従来のデータセンターをAI工場に変えるには、ハードウェアの導入、ソフトウェアの最適化、アーキテクチャ設計の橋渡しをする専門的な知識が必要です。イントロールでは、このような先進的な GPUインフラ・ソリューションを導入してきました。複雑なMVLinkの導入からOmniverseデジタルツインの実装に至るまで、NVIDIAのエコシステムに対する当社のチームの深い経験は、最先端のインフラストラクチャに関連する一般的な急な学習曲線なしに、組織がこのパラダイムシフトをナビゲートするのに役立ちます。推論AI機能をスケールアップする場合でも、最初のAI工場フロアを構築する場合でも、スペシャリストと提携することで、急速に進化するこの状況において、タイム・ツー・バリューを劇的に加速することができます。準備はできましたか? 今すぐお電話ください。

結論コンピューティングの第3の時代の到来

COMPUTEXは、NVIDIAがより高速なチップを披露しただけではなかった。ジェンセンが披露したのは、我々が慣れ親しんできた「昨年より20%向上した」というお決まりの発表を吹き飛ばすものだった。彼は、コンピューターが何のためにあるのかを根本から見直そうとしている。我々は、数字を計算し、データを移動させるマシンを作ることに何十年も費やしてきた。そして今、エヌビディアはインテリジェンスを主要なアウトプットとして製造するシステムを構築している。それは、書類整理棚と脳を比較するようなものだ。確かに、どちらも情報を保存しているが、一方はそこに置かれ、もう一方は新しいアイデアを生み出す。このシフトは、コンピューティング・システムの構築方法、展開方法、測定方法のすべてを変えることに気づくまでは、意味論に聞こえるかもしれない。

「私たちはこれまで、PCからインターネット、クラウド、モバイルクラウドと、何度もITの次世代を創造してきた。私たちはそれを何度も繰り返してきた。しかし今回は、次世代のITを創造しているだけでなく、まったく新しい産業を創造しているのです」。

この移行は、パーソナル・コンピューティング革命、インターネット/クラウド時代に続く、第3の大きなコンピューティング・パラダイム・シフトを意味する。このようなAIインフラ機能を統合する組織は、業界を問わず、乗り越えられない競争優位性を確立する可能性が高い。

今日、計算知能の工場は建設中である。問題はもはや、AIがビジネスを変革するかどうかではなく、コンピュータ・インテリジェンスが電気と同じくらい事業運営の基本となる世界で競争力を維持するためのインフラを、あなたの組織が構築しているかどうかである。

参考文献とその他のリソース

NVIDIA公式Blackwellアーキテクチャ概要: https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

NVIDIA MVLink テクニカルドキュメント: https://developer.nvidia.com/mvlink

NVIDIA オムニバース・プラットフォーム https://www.nvidia.com/en-us/omniverse/

アイザック・ロボティクス・プラットフォーム https://developer.nvidia.com/isaac-ros

NVIDIA AIエンタープライズ https://www.nvidia.com/en-us/data-center/products/ai-enterprise/

NVIDIA Computex 2025 公式プレス資料: https://nvidianews.nvidia.com/news/computex-2025

NVIDIA CUDA-X ライブラリの概要: https://developer.nvidia.com/gpu-accelerated-libraries

NVIDIA DGXシステム: https://www.nvidia.com/en-us/data-center/dgx-systems/